이제 LM Studio도 설치가 끝났으니, 본격적으로 모델을 다운받고 실행해볼 차례입니다.

이번 편에서는 모델을 어디서 찾고, 어떻게 받아서, 어떤 설정을 해야 작동하는지 알려드릴게요.

1. 모델은 어디서 다운받을까?

LM Studio는 기본적으로 Hugging Face에 올라온 공개 모델들을 쉽게 검색하고 받아올 수 있게 되어 있어요.

처음엔 좀 낯설 수 있지만, 막상 해보면 꽤 편합니다.

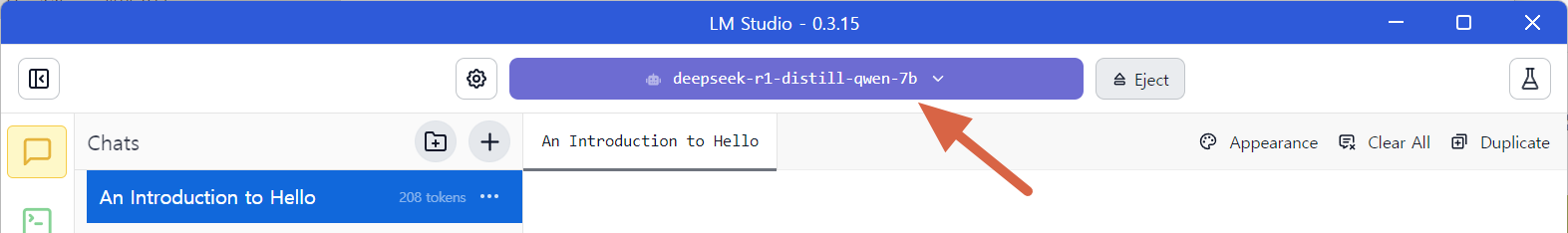

- LM Studio를 실행한 후 상단의 Model 탭을 클릭

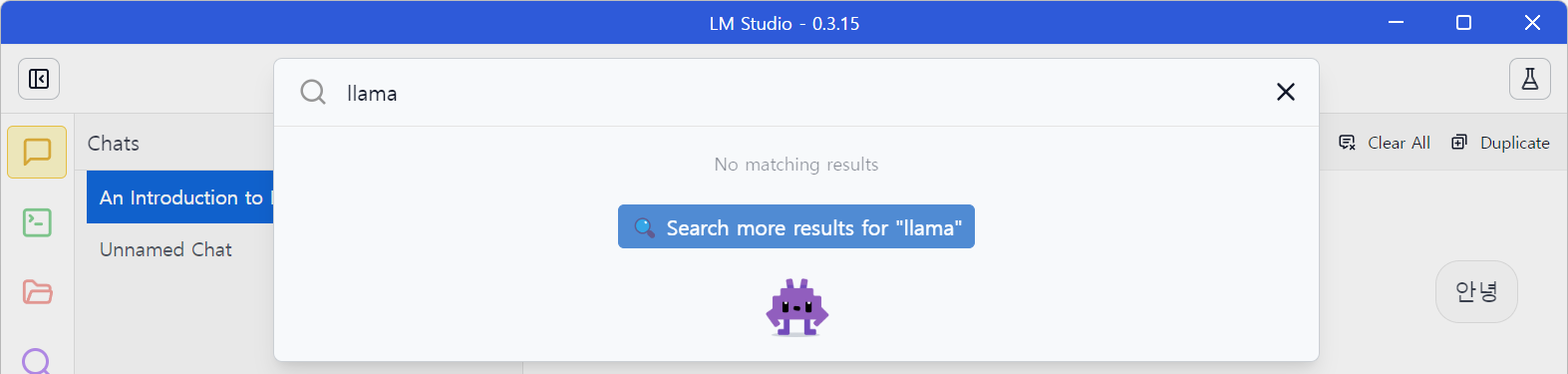

검색창에 원하는 모델 이름을 입력 (예: mistral, llama3, phi2, koalpaca 등)

처음에는 검색 결과가 안 나올 수도 있어요. 그럴 땐 검색창 아래쪽에 나오는 ‘Search more results for "llama"’ 버튼을 눌러주면 Hugging Face에서 더 많은 결과를 가져옵니다

그럼 이렇게 제공되는 모델이 검색되어 나오게 되요.

Mistral이나 LLaMA3 같이 덩치 큰 모델은 30GB가 넘는 경우도 있어서, 저장공간이 부족한 경우엔 중간 스펙 모델로 시작하는 걸 추천드려요.

원하는 모델 선택 후 다운로드 버튼을 누르면 모델을 자동으로 받아서 설치해 줍니다

2. 어떤 모델을 골라야 할까? (추천 모델)

처음엔 뭐가 뭔지 헷갈릴 수 있어요. 아래는 제가 직접 써보고 추천하는 모델들이에요:

- Mistral 7B Instruct: 영어 중심이지만 성능 좋고 빠름

- LLaMA3 8B: Meta에서 만든 최신 모델, 대화 성능 좋음

- Phi-2: 가벼운 모델인데도 놀라운 성능, CPU 환경에서 추천

- KoAlpaca Polyglot: 한국어 지원되는 대표 모델 (한글 위주 작업용)

솔직히 모델이 너무 많아서 선택이 어려운데 가장 많은 다운로드를 한 최신 모델 위주로 정렬해서 찾아나가는게 편해요

한글 위주로 쓸 계획이라면, 'Korean' 키워드로 검색해서 Most Downloads로 정렬해보는 게 팁입니다.

전 AI 전문기업 Linkbricks Horizon-AI 의 지윤성 대표가 파인튜닝한 모델 Linkbricks-Horizon-AI-Korean-llama-3.1-sft-dpo-8B 을 받아서 테스트 해보기로 합니다

상황에 따라 GPU 지원 버전과 CPU 전용 버전이 나뉘는 경우도 있어요.

파일 이름에 Q4_K_M, Q8_0, GGUF, GPTQ 같은 게 붙어 있으면 압축률, 정밀도, 포맷 차이를 뜻합니다. 초보자는 GGUF 형식의 Q4_K_M 버전을 추천드려요.

3. 모델 세팅은 어떻게?

모델을 다운로드한 뒤에는 Chat 탭에서 아래와 같은 설정 화면이 나와요.

처음 보면 좀 복잡해 보이지만, 기본값으로도 잘 작동하고요. 아래 항목만 살펴보면 됩니다:

주요 설정 설명

- Context Length

→ 문맥 길이를 의미합니다. 기본값 4096으로 두면 무난합니다.

→ 숫자가 클수록 긴 대화나 문서를 처리할 수 있지만, 메모리 사용량이 늘어나요. - GPU Offload

→ GPU가 있을 경우 계산의 일부를 넘기는 설정입니다.

→ 숫자가 클수록 GPU를 더 많이 활용하니, 사양에 맞춰 자동 설정해주면 됩니다.

→ GPU가 없으면 이 옵션은 무시돼요. - CPU Thread Pool Size

→ CPU 몇 코어를 사용할지 설정합니다.

→ 일반적으로 6~8 정도로 두면 적당합니다. 너무 높이면 전체 시스템이 느려질 수 있어요. - Evaluation Batch Size

→ 처리 속도에 영향을 줍니다. 기본값 512 유지 추천! - Keep Model in Memory

→ 체크하면 모델을 메모리에 유지해서 재실행 시 로딩이 빠릅니다. 켜두는 걸 추천! - Try mmap()

→ 모델 로딩 방식을 바꾸는 실험적 기능인데, 대부분 켜져 있어도 문제 없습니다. - Flash Attention

→ 최신 GPU에서만 성능 향상이 있는 실험적 기능입니다. 대부분의 사용자에겐 꺼두는 걸 추천 - K/V Cache Quantization Type

→ 캐시를 양자화해 메모리 사용을 줄이는 옵션인데, 아직은 실험적 단계예요. 초보자라면 건드리지 않아도 됩니다.

설정은 너무 깊이 고민 안 해도 돼요. 대부분 기본값으로도 충분히 쓸 수 있습니다. 혹시 모델이 자꾸 느리거나 에러가 난다면, CPU Thread 수를 줄이거나 더 가벼운 모델로 교체해보세요.

세팅을 마쳤으면, 텍스트 입력창에 문장을 넣고 Enter를 눌러보세요.

예: “오늘 점심 뭐 먹을까 추천해줘”

간단한 질문에 GTX 3070 GPU인데도 빠르게 토큰 생성이 이뤄집니다. 다만 실시간 웹검색을 통한 기능은 제공되지 않아요

다만 모델이 학습된 날짜를 기준으로 정적으로 데이터를 제공하기 때문에 실시간 상황은 알려주질 못해요. 오늘 날짜를 알려달라고 해도 2024년 7월을 얘기하고 있네요. 그리고 ChatGPT처럼 실시간 웹검색을 지원해주지도 않고 있습니다. 이는 외부API를 통해 해결이 가능한데 완전체가 아니니 아쉽네요

4. 모델 작동이 안 될 땐?

- 모델이 안 뜬다면? → Model 탭에서 다시 선택 후 Chat 탭 이동

- 실행이 느리다면? → 좀 더 가벼운 모델 (phi2 등)로 바꿔보세요

- 계속 에러가 난다면? → Settings 탭에서 모델 경로나 메모리 설정 확인

5. 마무리하며

이렇게 해서 모델 다운로드부터 채팅 시작까지 기본적인 준비는 끝났습니다.

직접 해보시면, 생각보다 로딩도 빠르고 꽤 똑똑하게 대답해서 놀라실 거예요.

저는 개인적으로 Phi-2와 Mistral을 많이 쓰는데, 빠르고 실수도 적어서 만족 중입니다.

다음 편에서는 이 모델들을 어떻게 실제 업무나 생활에 활용할 수 있는지도 보여드릴게요!